首先打开ollama官网:https://ollama.com

下载,一步步安装即可。

CMD命令窗口运行,启动deepseek-r1模型:

ollama run deepseek-r1:7b根据自己显卡大小,选择对应的参数规模。

另外有人反馈,大模型在执行的时候,回答很慢,GPU几乎没动,全都是CPU在跑。大概率是安装了老版本的Ollama,官网下载最新的文件重新安装即可。

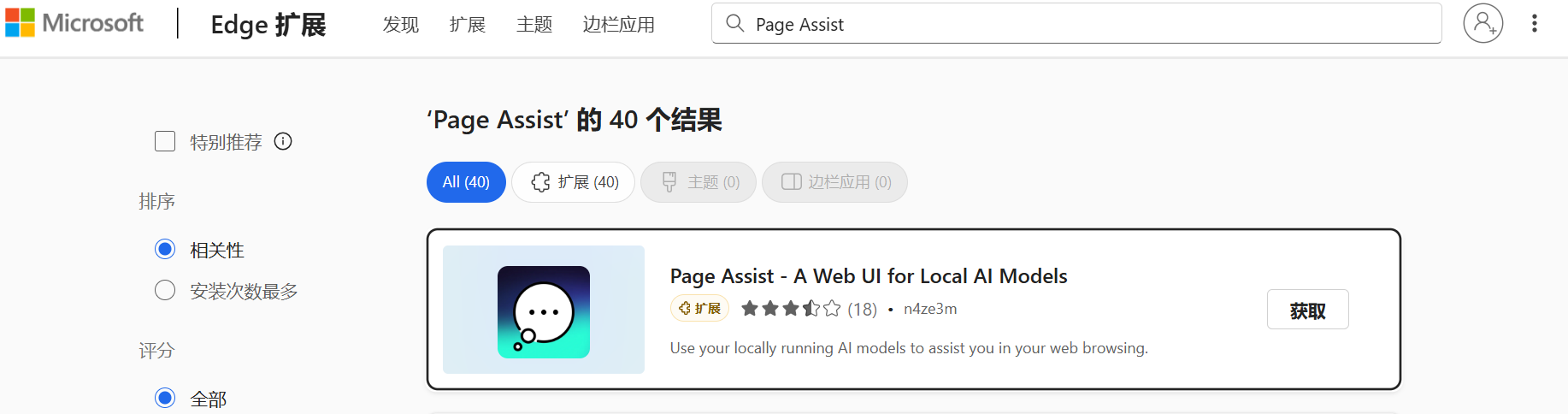

安装Page Assist插件

根据浏览器不同,下载 Page Assist 插件。

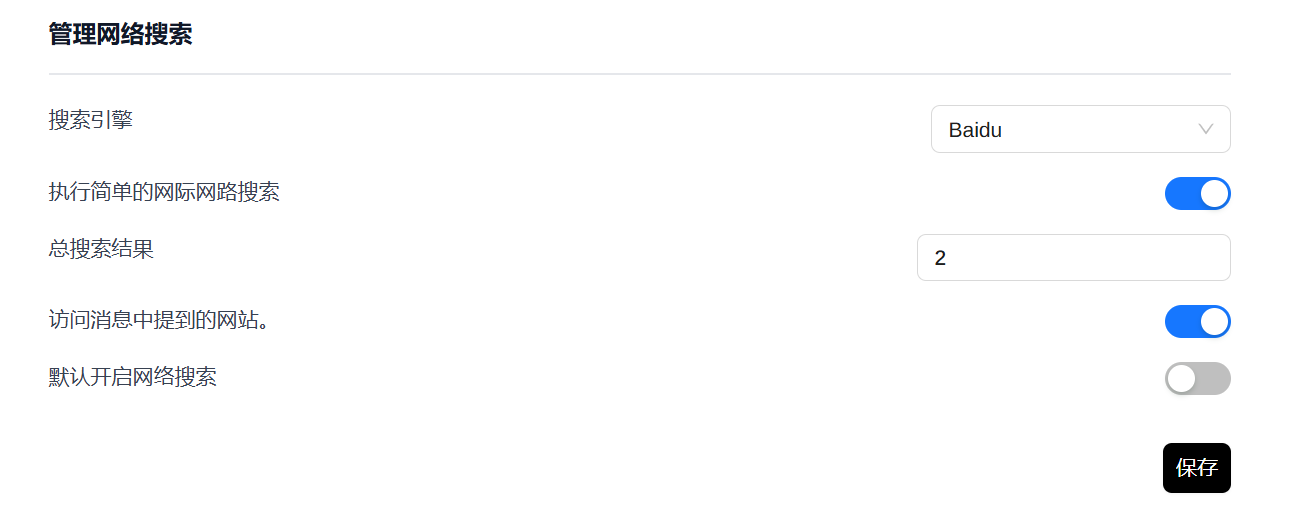

设置联网搜索

依然是右上角设置齿轮,【一般设置】,下方有个【管理网络搜索】,选择合适的搜索引擎,总搜索结果默认是2,可以适当调大一些,这样参考网络资源的权重更大。

记得点击保存。

回到聊天页面,打开聊天框下方的【搜索互联网】开关,联网搜索功能就搞定。

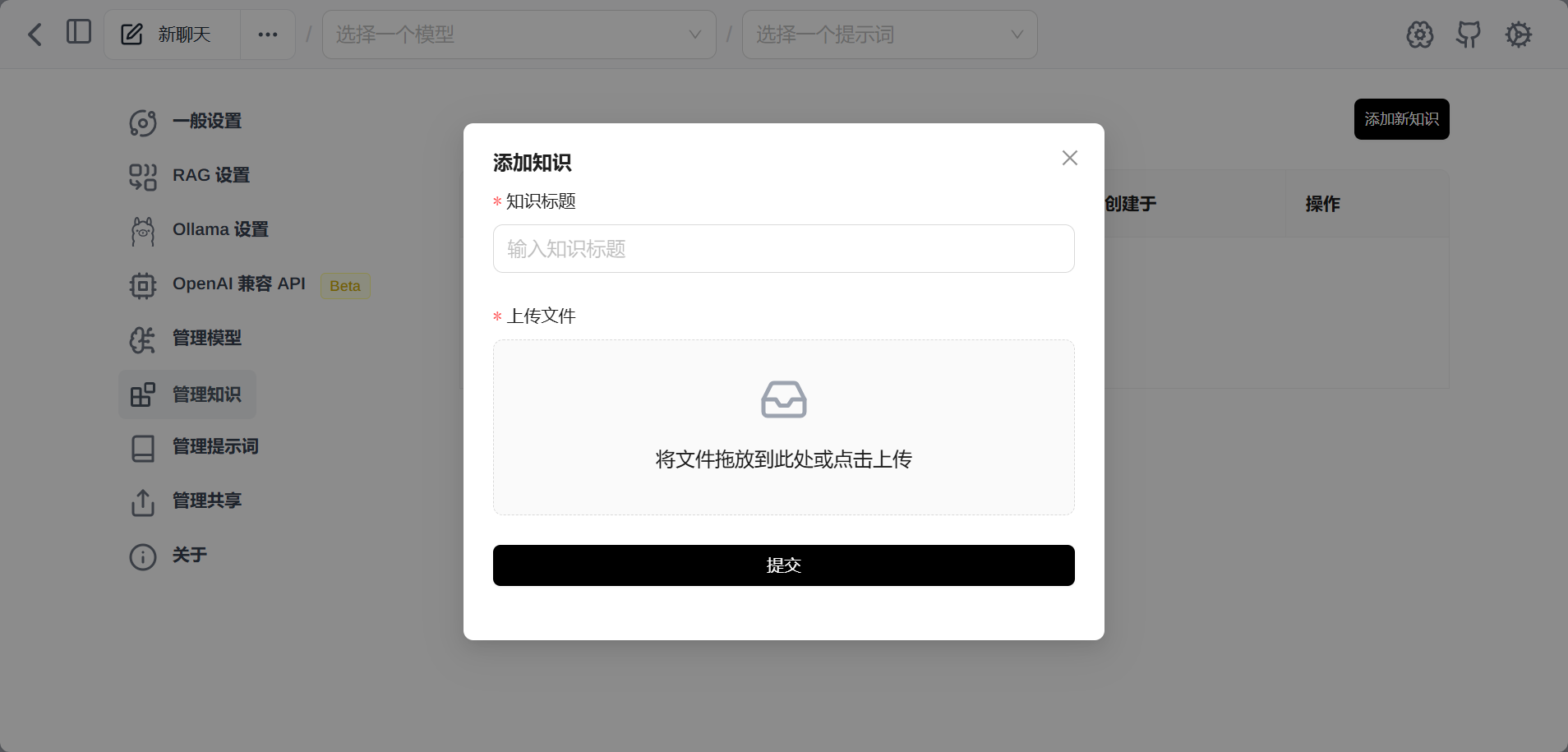

搭建私人知识库

CMD窗口运行命令:

ollama pull nomic-embed-text回到设置,【RAG设置】,文本嵌入模型选择【nomic-embed-text:latest】,保存。

文本嵌入模型的作用是,让大模型理解我们的文本资料。

左侧菜单【管理知识】,【添加新知识】,指定知识的标题,并上传我们的本地资料,提交。

提问:

DeepSeek-R1是什么?本地大模型完美地回答了我们的问题,知识库搭建完成!

简单回顾一下,这次的方案:Ollama + Page Assist插件,没有docker的复杂配置,而且完美地实现了本地部署+联网搜索+知识库。

参考:

[1] DeepSeek R1本地部署+知识库+联网搜索,终极版方案 – 知乎

[2]最全本地部署 DeepSeek R1 教程(适用于 Mac、Windows、Linux)-腾讯云开发者社区-腾讯云

发表回复